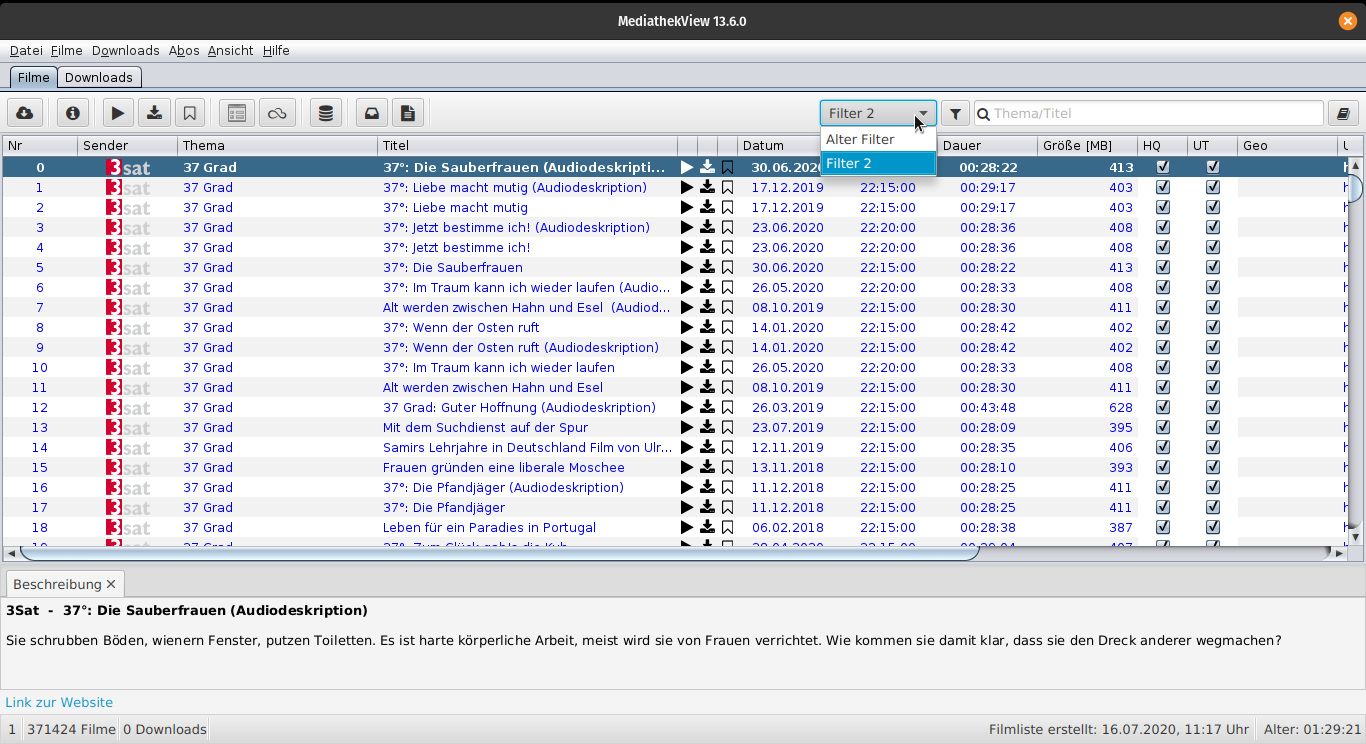

Das Programm MediathekView durchsucht die Mediatheken verschiedener überwiegend deutschsprachiger öffentlich-rechtlicher Sender, lädt Beiträge daraus herunter oder spielt diese ab (mit VLC Media Player oder mit einem Programm eigener Wahl). Es können auch Sendereihen/Serien abonniert werden.

Derzeit werden die Mediatheken der folgenden Sender unterstützt:

- ARD (Das Erste)

- alpha

- BR (Bayerischer Rundfunk)

- HR (Hessischer Rundfunk)

- MDR (Mitteldeutscher Rundfunk)

- NDR (Norddeutscher Rundfunk)

- RBB (Rundfunk Berlin-Brandenburg)

- rbtv (radiobremen)

- SR (Saarländischer Rundfunk)

- SWR (Südwestrundfunk)

- WDR (Westdeutscher Rundfunk)

- ZDF (Zweites Deutsches Fernsehen)

- ZDFinfo

- ZDFneo

- zdf-tivi

- Gemeinschaftsprogramme von ARD und ZDF

- 3Sat

- Arte (deutsch, englisch, französisch, spanisch, italienisch und polnisch)

- Funk

- Kika (Kinderkanal von ARD und ZDF)

- Phoenix

- DW TV (Deutsche Welle)

- ORF (Österreichischer Rundfunk)

- SRF (Schweizer Rundfunk) inkl. Podcasts

MediathekView wird in mehreren Paketen auf der Webseite angeboten. , darunter Installer für Windows & Linux.

Zusätzlich zu den Installern sind auch Portable Varianten vorhanden z.B. als Zip oder tar.gz. Diese Pakete beinhalten bereits die benötigte Java Version, Java muss also nicht installiert sein.

Für RPM-basierte Linux Pakete steht auch ein GPG Key zur Verfügung, mit dem das RPM-Pakete anhand seiner Signatur verifiziert werden kann. Dieser kann mit diesem Kommando importiert werden:

sudo rpm --import https://download.mediathekview.de/stabil/MediathekView-rpm-signature-2021.pubmacOS: Für macOS werden fertige DMG-Images sowohl für Intel als auch Apple Silicon Rechner angeboten.

Siehe Anleitung

Bei Fragen, Hilfe, gesuchten Sendungen oder sonstigen bitte das Forum verwenden.

Für Bugs siehe Contribution Guide.

See / Siehe Contribution Guide

- Die dargestellten Länderflaggen wurden von Freepik auf www.flaticon.com erstellt.